Каждому вебмастеру необходимо знать, какие фильтры поисковых систем существуют и каким образом можно их избежать. Желаете оградить свой сайт от понижения в выдаче? Прочтите данную публикацию! В ней дается описание всех фильтров, которые существуют в данный момент. Сейчас август 2014 года. Также в этой статье даны советы, помогающие вывести интернет-страницы из-под санкций поисковых машин.

Стараясь очистить интернет от дорвеев и сайтов, которые создаются только с целью получения с них прибыли, популярные поисковики ввели специальные алгоритмы, с помощью которых сортируются ресурсы сети. Называются они — фильтры поисковых систем. Каждый из них отслеживает определенный тип сайтов и автоматически понижает их в выдаче или совсем выбрасывает из поиска. Именно поэтому следует знать о каждом из них.

Содержание статьи:

Фильтры поисковой системы Яндекс

Вы наверняка уже в курсе, что Яндекс решил отменить ссылочное ранжирование. Другими словами — данная поисковая система не желает учитывать внешние линки на ресурс. Такое решение приняла администрация поисковика потому, что устала бороться с желающими вывести свои сайты в ТОП черными методами и при помощи автоматических систем продвижения. А чтобы робот быстрее определял ресурсы недобросовестных вебмастеров, были введены специальные алгоритмы. Все они описаны ниже, в этой статье. Но в данной ее части хотелось бы поведать о нововведении Яндекса, которое называется ротацией.

Кроме того, что сайты контролируются специальными алгоритмами поисковых систем, и на те ресурсы, которые считаются некачественными, накладываются фильтры, отныне все сайты будут попадать в выдачу не как раньше – старые и трастовые — в ТОПе, а молодые — на задворках поисковой выдачи. Разработчики Яндекса решили дать шанс и новым ресурсам, позволяя им появляться на первых местах. Таким образом, сайты, на которых публикуется полезный контент, получат больше посетителей. По результатам того, как люди будут вести себя на страницах ресурса, поисковые роботы будут выставлять сайтам критерии качества поведенческих факторов. А от последних зависит, на каких позициях в поисковой выдаче окажутся странички ресурса.

Фильтр АГС Яндекса

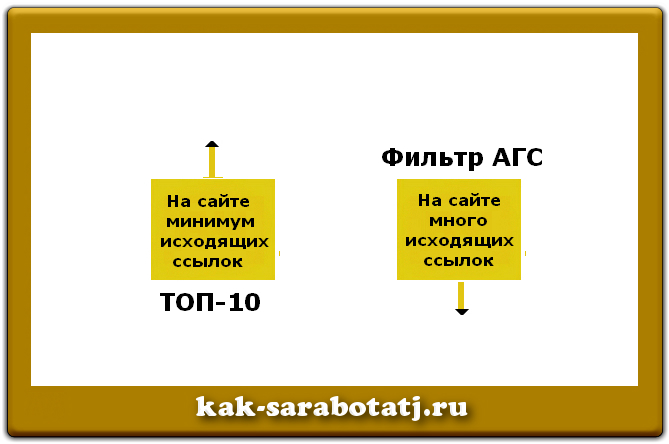

Обычно, при попадании сайта под АГС, в индексе наблюдается не более двадцати страниц. Иногда там остается только главная. Количество проиндексированных страничек можно увидеть в ЯндексВебмастере или если ввести адрес своего ресурса в поисковую строку расширенного поиска Яндекса. Причинами попадания сайта под фильтры поисковых систем такого типа, могут быть следующие:

— посещаемость в пределах сотни человек (поисковик считает такой сайт неинтересным для людей);

— большое количество исходящих ссылок, анкорами которых являются исключительно поисковые фразы (внешних линков на сайте должно быть менее пятидесяти процентов, относительно количества страниц ресурса);

— неуникальный бесплатный шаблон сайта;

— множество навигационных страниц, на которых размещен текст объемом не более ста символов.

Что следует делать, чтобы не попасть под фильтры Яндекса, в частности под АГС?

Необходимо создавать сайт, который специалисты поисковых систем называют белым проектом. То есть сделать уникальный шаблон самостоятельно или заказать его у дизайнера в данной бирже. Нужно наполнять ресурс уникальными статьями, каждая из которых объемом не менее трех тысяч символов без пробелов. Кроме того, не следует размещать на сайте множество исходящих ссылок. Лучше использовать редирект для линков на внешние ресурсы. А если вы зарабатываете на своем сайте, то вам следует продавать не более одной ссылки со страницы. Причем на одну публикацию с внешним линком, должно приходится пять статей без ссылок на другие проекты.

Что делать, если сайт попал под фильтр Яндекса – АГС?

СЕО-специалисты считают, что вывести свой ресурс из-под АГС практически невозможно. Якобы только с помощью соешника можно достичь положительных результатов. В некоторых случаях это действительно так. Но и своими силами можно попытаться достичь успеха. Сначала следует написать в службу поддержки поисковой машины Яндекс. Используйте для этого данный адрес feedback2.yandex.ru/search/?from=webmaster. Там надо спросить – почему были применены санкции против вашего сайта. Потом нужно опубликовать на своем ресурсе не менее пятидесяти процентов статей, от общего количества уже существующих. Надо убрать все внешние ссылки или уменьшить их количество. Следует уникализировать шаблон сайта. Кроме того, необходимо увеличить посещаемость своего ресурса. Фильтры поисковых систем устраняются долгое время. Избавиться от АГС можно только спустя полгода.

О том, как накладываются фильтры поисковых систем, рассказывается в видео, которое представлено ниже. В нем освещаются очень интересные факты, которые меняют взгляд на многие вещи. Например, специалист, рассказывающий в видео об АГС Яндекса, утверждает, что уникальность, которая важна для поисковиков, сильно отличается от той, которую принято выдерживать. Все пользователи интернета ориентируются на количество совпадающих фраз в разных текстах, размещенных в интернете. А специалисты поисковиков считают уникальными тексты – описания чего-то нового, чего нет в глобальной сети. К примеру, я написала текст о том, как окрасить ковролин. Никто этим не занимается, и поэтому нет тех, кто пишет на данную тему. Поэтому публикация об окраске коврового покрытия приносит мне ежедневно не менее тридцати посетителей из поисковых систем.

Фильтр Яндекса под названием «Ты последний»

Чтобы люди создавали полезные сайты, Яндекс придумал фильтр под названием «Ты последний». Он помогает отсеивать конкретные страницы сайта. Если на них нет полезной информации, то странички оказываются вне поисковой выдачи. Попытавшись найти их в режиме «Показать все без исключения», можно найти часть из них на последних местах. Такого типа фильтры поисковых систем можно считать полезными, ведь они исключают из индекса сайты с копипастом. Теперь создателям дорвеев, как и владельцам блогов на популярных блогхостингах, нет смысла воровать чужой контент – их ресурсы выпадают из индекса. Кроме того, алгоритм «Ты последний» выкидывает из индекса страницы дорвеев и сайтов-линкопомоек.

Меры, предотвращающие попадание сайта под фильтр «Ты последний»

Чтобы ваш сайт не попал под фильтры поисковых систем такого типа, нужно создавать уникальный и качественный контент. Это значит – каждая страница ресурса должна содержать тексты, написанные вами или нанятыми вами копирайтерами. Уникальность статей не должна быть менее девяноста семи процентов по «Advego Plagiatus». Скачать программу можно тут. Кроме того, на каждой станице сайта должны быть размещены уникальные картинки и видео. Прочтите о том, как сделать картинку уникальной. Вам понадобится это, если у вас нет возможности самостоятельно создавать фотографии.

Способ вывода сайта из-под фильтра «Ты последний»

Если сайты попадают под фильтры поисковых систем, то первое, что вебмастера делают – ведут переписку со службой поддержки. Вы узнали, что на ваш сайт наложили фильтр «Ты последний»? Тогда спросите в саппорте Яндекса, что именно не так на вашем ресурсе. Рекомендуется сразу же начать корректировку текстов. В них нужно добавить изображения и видео, которые подходят тематически каждой статье. А самое главное – отредактировать содержимое публикаций, разделив его на абзацы, добавив списки и удалив предложения, которые не несут смысловой нагрузки. Также нужно добавить новые познавательные тексты с изображениями и видеороликами. Если робот найдет на сайте полезные статьи, то фильтр будет снят автоматически через один-два апдейта.

Фильтр «Ты спамный»

Из-за того, что нерадивые вебмастера создавали множество дорвеев, страницы которых буквально забивались поисковыми запросами, были созданы фильтры поисковых систем, отсеивающие такие ресурсы. Алгоритм Яндекса «Ты спамный» удаляет из выдачи страницы, на которых робот находит слишком большое количество поисковых запросов. Допустимое количество – от двух до четырех процентов. Четыре и более процента ключевых вхождений в тексте – это уже переспам. Если таких заспамленных страниц очень много на сайте, то фильтр накладывается на весь ресурс. Улучшить индексацию ресурса можно умеренно оптимизированными статьями и путем создания полноценного семантического ядра.

Чего нельзя делать, чтобы не попасть под фильтр «Ты спамный»?

Ранее владельцы сайтов старались выделить ключевые фразы при помощи специальных тегов, например, жирным шрифтом или курсивом. При этом их тексты буквально пестрели из-за такого оформления. Робот, как и люди, реагировал на эти выделения, а потому страницы с подобным оформлением попадали в ТОП. Чтобы этого не происходило, фильтры поисковых систем отсеивают страницы и даже целые сайты с неправильным оформлением контента.

Нельзя в текст вписывать множество ключевых слов, идущих через запятую. Не стоит уникализировать текст, используя транслитные буквы. То есть вместо кириллических «а» и «о» не нужно вписывать латинские буквы. Роботы это распознают и специальные фильтры поисковых систем способствуют тому, чтобы такие страницы выпадали из индекса. Не надо заключать часть текста в тег «noindex». Запрещено использовать несколько ключевых словосочетаний в титле страницы или в ее заголовке. Кстати, на одной странице должен быть только один заголовок в теге «h1».

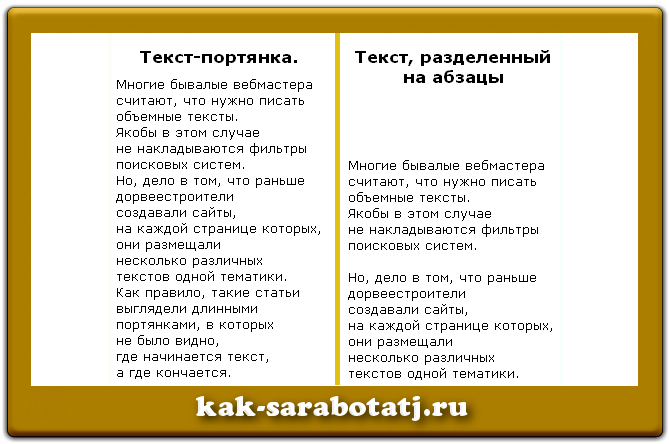

Многие бывалые вебмастера считают, что нужно писать объемные тексты. Якобы в этом случае не накладываются фильтры поисковых систем. Но, дело в том, что раньше дорвеестроители создавали сайты, на каждой странице которых, они размещали несколько различных текстов одной тематики. Как правило, такие статьи выглядели длинными портянками, в которых не было видно, где начинается текст, а где он кончается. Поэтому согласно рекомендациям работников поисковых систем, большой текст – свыше пяти тысяч знаков, кроме того, что должен быть разделен на абзацы, еще должен правильно оформляться. Необходимо:

— озаглавливать части статьи, выделяя их заголовками «h2-h6»;

— включать в тело публикации списки и таблицы;

— размещать в тексте тематичные картинки и видеоролики;

— внедрять в тело статьи ссылки на другие статьи сайта и на полезные ресурсы интернета.

Что делать, если сайт под фильтром Яндекс — «Ты спамный»?

Вывести сайт из-под этого фильтра не всегда просто, но возможно. В рекомендациях поисковых систем, указывается, что сначала нужно отредактировать все тексты, удалив из них большое количество ключевых фраз. Процентное содержание поисковых словосочетаний в каждой статье, можно проверить в программке «Textus Pro». Желательно удалить переспам из тайтла страницы и из ее названия. Если ключевиков немного, стоит найти однокоренные им слова и заменить их синонимами.

Накрутка поведенческих факторов. Фильтр Яндекса

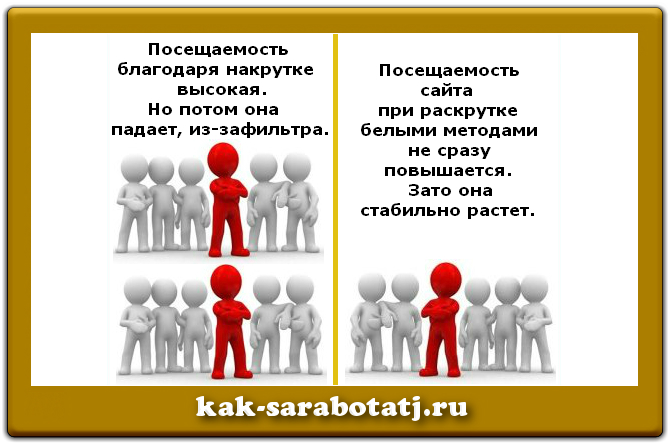

Если раньше многие СЕО-специалисты, как и отдельные вебмастера, легко могли продвинуть свои сайты или интернернет-страницы своих клиентов за счет того, что закупали ссылки, то сейчас они столкнулись со сложностями, ведь в данный момент поисковиками учитываются поведенческие факторы. По этой причине были созданы специальные системы накрутки количества посетителей ресурса, с возможностью манипуляции их поведением на сайте. Поэтому появились новые фильтры поисковых систем, наказывающие ресурсы нерадивых вебмастеров за накрутку.

Пока еще из индекса выпадают только те страницы сайтов накрутчиков, которые были заточены под поисковые запросы, что применялись для накрутки. Эти странички попадают за пределы ТОП-100 поисковой системы Яндекс. Как и все фильтры поисковых систем, этот снимается за полгода. Поэтому не стоит пользоваться системами накрутки, ведь эффект от этого непродолжительный – всего пара месяцев. Все время вывода ресурса из-под фильтра, придется вести переписку со службой поддержки поисковой системы. Это же стоит сделать, если вы не накручивали поведенческие факторы, а за вас это сделали ваши конкуренты.

Рекомендую посмотреть видео, в котором объясняется, что такое поведенческие факторы.

Аффилиат-фильтр Яндекса

До недавних времен в погоне за большим количеством клиентов для своих заказчиков – крупных компаний, некоторые СЕО-специалисты создавали множество сайтов, которые продвигались по одному списку поисковых запросов. Таким образом, эти ресурсы буквально заполоняли ТОП-10 поисковика и потому у сайтов, которые продвигались белыми методами, не было даже малейшего шанса попасть в выдачу в первой десятке. Но теперь фильтры поисковых систем заботятся о том, чтобы на каждой странице показывались различные ресурсы, принадлежащие разным компаниям. Также в выдаче не появляются сайты, полностью копирующие основной, продающий какой-то продукт. То есть ресурсы–копии не видны в выдаче вообще.

Почему может быть наложен на сайт аффилиат-фильтр?

Фильтры поисковых систем, устраняющие из поиска аффилиат-проекты, ориентируются на следующие критерии:

— совпадение контактных данных на ресурсах и в ЯндексСправочнике;

— если указаны одни и те же данные владельца при регистрации различных доменных имен;

— сайты находятся на одном хостинге;

— похожие шаблоны, названия сайтов и их структура;

— один и тот же текст в описании компании или ресурса;

— идентичный каталог товаров;

— нахождение сайтов в одном аккаунте ЯндексВебмастера и в Метрике;

— идентичные семантические ядра.

Как вывести сайт из-под аффилиат-фильтра?

Как и все фильтры поисковых систем, этот устраняется за счет изменения каких-то данных. В данном случае нужно поменять контакты и сведения о владельце домена. Также необходимо видоизменить описание ресурса, компании или ее деятельности. Кроме того, нужно полностью уникализировать описание продукции в каталоге и создать уникальные сниппеты. Если были внесены все необходимые изменения, то сайты-аффилиаты выйдут из под фильтра и будут показываться в выдаче поисковиков, как и основной ресурс.

Фильтр за контент «для взрослых»

В былые годы в поисковой выдаче можно было наткнуться на сайты для взрослых, по самым обычным запросам. Теперь этого не происходит благодаря тому, что фильтры поисковых систем не позволяют появляться сайтам «для взрослых» в выдаче. Чтобы санкции поисковиков не применялись к вашему сайту, не размещайте на нем видео, фото и тексты эротического содержания. Дабы вывести ресурс из-под фильтра, нужно удалить весь, компрометирующий контент. Через два апдейта сайт появится снова в выдаче Яндекса.

Фильтр за агрессивную рекламу

Пользователи интернета давно уже устали от всплывающей рекламы. Яркие, мигающие баннеры и поп-ап-окна – все это мешает посетителям ресурса воспринимать информацию, которая там размещена. Если вы часто переходите из поисковых систем на сайты интересной вам тематики, то наверняка заметили, как на некоторых установлены поп-ап-окна, надоедающие читателю своими предложениями подписаться на рассылку, заказать услуги или купить курсы, позволяющие получать доход с сайта. Такие ресурсы не выходят в ТОП-10, потому что они под фильтром Яндекса. После удаления агрессивной рекламы с сайта, он попадает в индекс через два апдейта.

Фильтры Google

В поисковой системе Гугл немного проще продвигать свои ресурсы. Однако и у нее есть свои алгоритмы, которые не позволяют засорять выдачу некачественными страницами. Все эти фильтры перечислены ниже, там же даны рекомендации, позволяющие избежать попадания под них и методы, помогающие устранить фильтры поисковых систем, в частности – Гугла. В этой части публикации приведены все настоящие алгоритмы, способствующие удалению страниц сайта из выдачи поисковика. Сейчас август 2014 года.

Фильтры Гугла. «Песочница»

Фильтры поисковых систем такого типа, возникли из-за того, что раньше желающие заработать много денег, не прикладывая максимум усилий, создавали дорвеи, засорявшие выдачу. Поэтому теперь в «Песочницу» попадают все молодые сайты, которые существуют не более одного года. Разработчики Гугл считают, что молодые ресурсы должны сначала показать, что они перспективные. Это значит – они регулярно наполняются контентом и на них создается правильная внутренняя перелинковка. А ссылочная масса такого ресурса растет постепенно. При этом доноры должны быть СДЛ-сайты той же тематики. Соблюдая эти правила, удается вывести ресурс из «Песочницы» примерно через полгода.

Что делать, если сайт попал под фильтр Гугла — «Дополнительные результаты»?

Многие движки интернет-ресурсов создают массу страниц, дублирующих содержание друг друга. Например, статья может дублироваться на страницах комментариев к ней, в метатегах и в списке публикаций одной категории. От таких дублей нужно избавляться. Обычно это делается путем, составления правильного robots.txt. Кроме того, дублями считаются страницы, на которых размещен копипаст – копии текстов, опубликованных на страницах других сайтов. Чтобы избежать фильтров поисковых систем и, в частности — «Дополнительные результаты», или вывести из-под фильтров сайт, необходимо размещать на своем ресурсе уникальный контент и устранить дубли страниц.

Фильтр «Панда»

Такого типа фильтры поисковых систем, накладываются на сайты, на страницах которых практически нет контента, очень много рекламы или статьи содержат бесполезную информацию. Признаки, по которым можно определить, что сайт находится под фильтром «Панда» — это существенное снижение трафика из поисковой системы Гугл. Так, происходит из-за того, что позиции отдельных страниц и сайта в целом, сильно понижаются. Не допустить попадания ресурса под фильтр или вывести его из-под «Панды» можно, если размещать только уникальный контент, минимум рекламы и если анонсы сайта добавляются в закладки социальных сетей.

Фильтр Гугла «Пингвин»

Сайты, на страницах которых размещается спам, обычно попадают под фильтры поисковых систем типа «Пингвин». Но что же именно Гугл считает спамом? Ниже приведен список:

— битые внутренние ссылки;

— неправильно сделанные редиректы;

— большое количество ключевых запросов в текстах;

— долгое время загрузки страниц сайта;

— внешние ссылки, ведущие на сайт с некачественных ресурсов;

— внешние линки с анкорами – ключевиками.

Если избегать всего перечисленного при ведении своего ресурса, то можно не допустить его попадания под фильтр. Чтобы вывести сайт из-под «Пингвина» нужно устранить все недочеты, которые перечислены в этом абзаце. Посмотрите видео по этой теме, чтобы понять, как не попасть под этот фильтр.

Менее известные фильтры Гугла

Большинству вебмастеров знакомы только основные фильтры поисковых систем. Но, кроме них, существуют еще и дополнительные:

— «Возраст домена», из-за него сайт понижается в выдаче, если он не развивается;

— «Линкопомойка» накладывается на сайт, если на нем много нетематичных ссылок и их количество на одной странице более пяти штук;

— «Много ссылок сразу» — так, называемый ссылочный взрыв, обычно возникает из-за прогона по каталогам или после оптовой закупки внешних линков;

— «Минус тридцать» — это понижение ресурса на тридцать пунктов в выдаче, накладывается фильтр за то, что используются методы продвижения посредством дорвеев, клоакинга и редиректов через JavaScript, такого типа фильтры поисковых систем сейчас довольно развитые, а потому быстро вычисляют нелегальные способы раскрутки;

— «Дублирующийся контент» накладывается за публикацию неуникальных текстов;

— «Бомбежка» — фильтр, под который попадают страницы с одинаковыми анкорами ссылок;

— «Фильтр по времени загрузки», необходимо устранить технические недочеты, чтобы странички ресурса загружались моментально, для улучшения этого параметра, рекомендуется разместить свой сайт на данном хостинге;

— «Битые ссылки» — последствия большого количества внутренних ссылок, отдающих ошибку 404;

— «Чрезмерная оптимизация» — фильтр за большое количество ключевых слов на каждой странице, оптимальным считается — в пределах двух-трех процентов.

Чтобы проверить сайт на фильтры Гугла, необходимо проанализировать выдачу и посмотреть на отметки в ГуглВебмастер. А затем, определив какой именно алгоритм поисковика посодействовал наложению фильтра, прочтите его описание на этой странице и устраните все недочеты. После этого вам удастся вывести вашу интернет-страничку из-под фильтра. Вообще, если не торопиться с раскруткой своего ресурса черными методами, то можно миновать любые фильтры поисковых систем. Белые методы включают в себя:

— написание качественного, уникального, сео-оптимизированного контента, если у вас нет времени на создание такого, то заказывайте его в этой бирже, там же можно дешево купить уникальные картинки;

— добавление анонсов статей в закладки социальных сетей и комментарии на сайт заказываются тут;

— постепенная покупка внешних ссылок на сайт осуществляется в данной бирже

Если следовать этим простым рекомендациям, то вашему ресурсу удастся миновать все фильтры поисковых систем.

Copyright © omirs.com